昆侖萬維開源7B和32B最強數學代碼推理模型,同規模下性能超越阿里QwQ-32B,對齊DeepSeek-R1

繼2025年2月發布首款中文邏輯推理大模型Skywork-o1之后,昆侖萬維天工團隊在此基礎上持續迭代優化,4月13日,重磅推出全新升級的Skywork-OR1(Open Reasoner 1)系列模型。

該系列在同等參數規模下實現了業界領先的推理性能,進一步突破了大模型在邏輯理解與復雜任務求解方面的能力瓶頸。同時,Skywork-OR1全面開放、免費使用,以完全開源的形式回饋開發者社區,堅定踐行天工團隊在推動AI技術發展上的開源路線。

此次開源涵蓋三款高性能模型,包括:

1. Skywork-OR1-Math-7B:聚焦數學領域的專項模型,同時也具有較強的代碼能力。

2. Skywork-OR1-7B-Preview:融合數學與代碼能力、兼具通用性與專業性的通用模型。

3. Skywork-OR1-32B-Preview:面向更高復雜度任務、具備更強推理能力的旗艦版本。

此次發布的Skywork-OR1系列采用業界最高透明度的開源策略:不同于其他前沿開源推理模型僅開放模型權重,昆侖萬維全面開源了模型權重、訓練數據集和完整訓練代碼,所有資源均已上傳至GitHub和Huggingface平臺。

配套的技術博客已發布于Notion平臺,詳細闡述了數據處理流程、訓練方法和關鍵技術發現,為社區提供了完全可復現的實踐參考。

目前,Skywork-OR1-7B和Skywork-OR1-32B的能力還在持續提升,在兩周內昆侖萬維還會發布兩個模型的正式版本,同時也會推出更為系統詳盡的技術報告,進一步分享我們在推理模型訓練中的經驗與洞察。公司相信,這種全方位的開源策略將有助于推動整個AI社區在推理能力研究上的共同進步。

Skywork-OR1系列開源地址:

https://github.com/SkyworkAI/Skywork-OR1

昆侖萬維天工團隊更多開源項目:

https://huggingface.co/Skywork

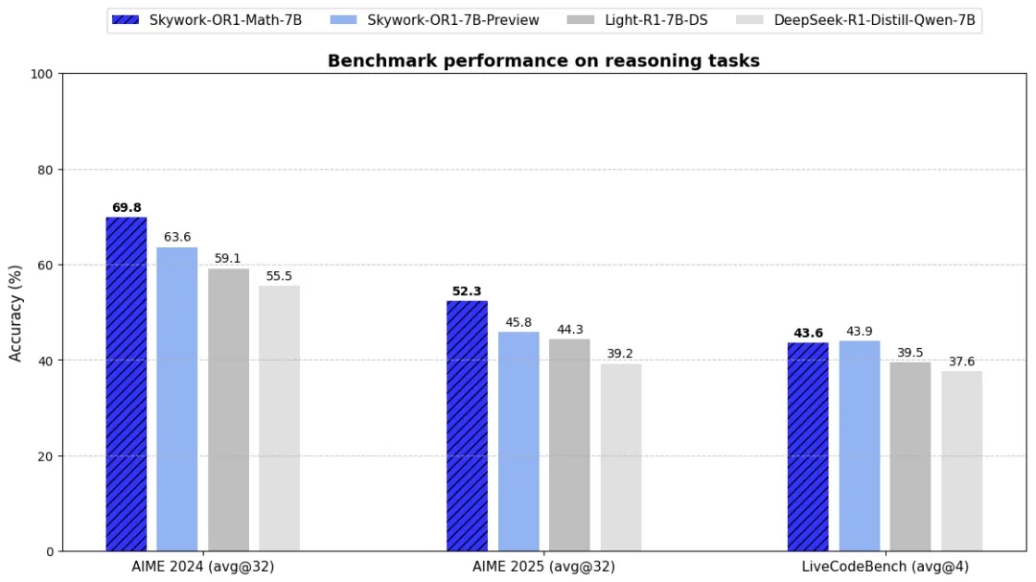

在評測方面,Skywork-OR1系列模型引入了avg@k作為核心評估指標,用于衡量模型在進行k次嘗試時成功解決問題的平均表現。相較于傳統的pass@k指標僅關注是否“至少一次成功”,avg@k能更細致地捕捉模型在多輪生成過程中的穩定性與整體推理能力,從而更全面反映其真實性能水平與實用價值。

在數學推理任務中:

1. 通用模型Skywork-OR1-7B-Preview和Skywork-OR1-32B-Preview在AIME24與AIME25數據集上均實現了同參數規模下的最優表現,展現出強大的數學推理能力。

2. 針對數學場景深度優化的專項模型Skywork-OR1-Math-7B更是在AIME24和AIME25上分別取得69.8與52.3的高分,遠超當前主流7B級別模型,充分驗證了其在高階數學推理任務中的專業優勢。

3. Skywork-OR1-32B-Preview在所有benchmark上均實現了對QwQ-32B的超越,并在更難的AIME25上基本與R1持平。

在競賽編程任務中:

1. 通用模型Skywork-OR1-7B-Preview與Skywork-OR1-32B-Preview在LiveCodeBench數據集上均取得了同等參數規模下的最優性能。

2. Skywork-OR1-32B-Preview表現尤為突出,其代碼生成與問題求解能力已接近DeepSeek-R1(參數規模高達671B),在大幅壓縮模型體量的同時實現了卓越的性價比,充分展現出天工團隊訓練策略的先進性。

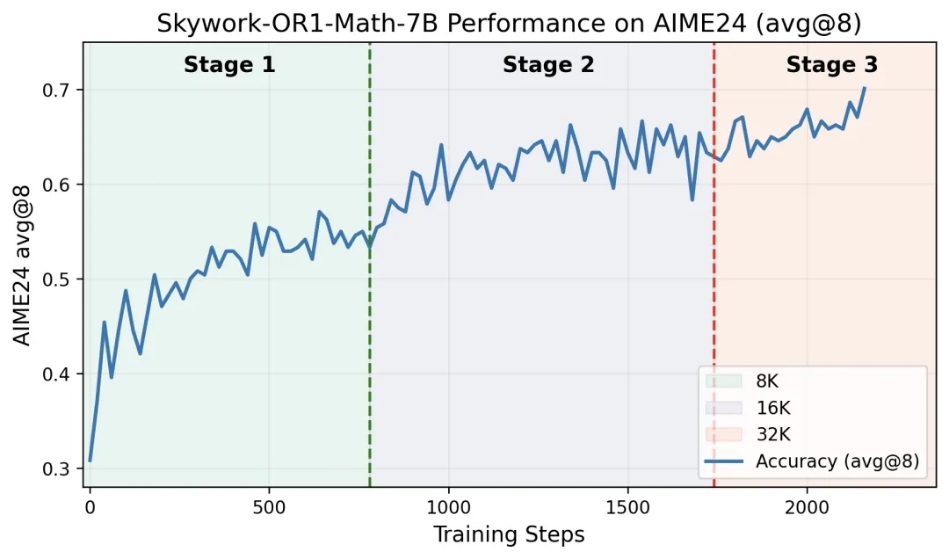

其中Skywork-OR1-Math-7B表現尤為亮眼,作為一個專注于數學推理能力的7B參數模型,通過多階段GRPO訓練在復雜數學問題上實現了卓越表現,同時在代碼任務上也有較強的泛化能力。下圖是該模型在AIME24上的訓練準確率曲線,清晰呈現了多階段訓練過程中性能的穩定提升軌跡。

Skywork-OR1-Math-7B最終模型在AIME24和AIME24上分別達到69.8%和52.3%,超越了OpenAI-o3-mini (low),達到了當前尺寸SOTA性能。值得注意的是,盡管該模型訓練過程中未專門針對代碼能力進行優化,但在代碼評測基準上Livecodebench從37.6%提升到43.6%,相比基線模型的顯著提升,這也表明昆侖萬維的訓練方法具有較好的領域泛化性。

自2023年以來,昆侖萬維堅定地開源大模型回饋開發者和行業。2025年開源的Skywork-R1V多模態視覺推理模型、SkyReels-V1面向AI短劇創作的視頻生成模型、Skywork-o1推理模型以及2024年開源的Skywork-Reward獎勵模型,不僅在Hugging Face上下載數據表現亮點,開發者的討論度和模型熱度依然居高不下。

當前,全球人工智能領域的競爭日趨激烈,競賽的焦點正逐步從基礎模型能力擴展到推理能力的比拼。AI大模型能否有效模仿人類的思維過程、具備邏輯推理和復雜任務的求解能力,已成為衡量技術先進性與通用智能潛力的關鍵指標。

在此背景下,為打破科技巨頭對核心AI大模型技術的壟斷壁壘,推動技術自主可控發展,中國多家企業紛紛投身于開源大模型生態的建設。未來,昆侖萬維仍繼續秉持“All in AGI 與 AIGC”戰略、“實現通用人工智能,讓每個人更好地塑造和表達自我”的使命,持續加大在通用大模型、開源框架和推理能力提升等方向的研究投入,力求在全球AI技術浪潮中搶占先機、塑造競爭優勢。

龔斯軒

- 免責聲明:本文內容與數據僅供參考,不構成投資建議。據此操作,風險自擔。

- 版權聲明:凡文章來源為“大眾證券報”的稿件,均為大眾證券報獨家版權所有,未經許可不得轉載或鏡像;授權轉載必須注明來源為“大眾證券報”。

- 廣告/合作熱線:025-86256149

- 舉報/服務熱線:025-86256144